Способность маленького ребенка усваивать язык просто поразительна. Но иногда малыш может выбрать ненормативное выражение, потому что не знает его значения. К счастью, при надлежащем воспитании ребенка можно научить не использовать оскорбительную лексику.

Источник: https://www.geekwire.com перевод: Шевченко Виолетта

Аналогичная ситуация может возникнуть с генерацией текстов на естественном языке (NLG) в машинном обучении, хотя этот процесс сильно отличается от того, как люди выбирают те или иные слова. Системы NLG, такие как OpenAI GPT-3, представляют собой нейронные сети, предварительно обученные на корпусе — огромной коллекции текстов. Модели используются для автоматического создания текста, похожего на человеческий и соотвествующего запросу. Результаты могут быть невероятно реалистичными, и иногда их трудно отличить от того, что написано реальным человеком.

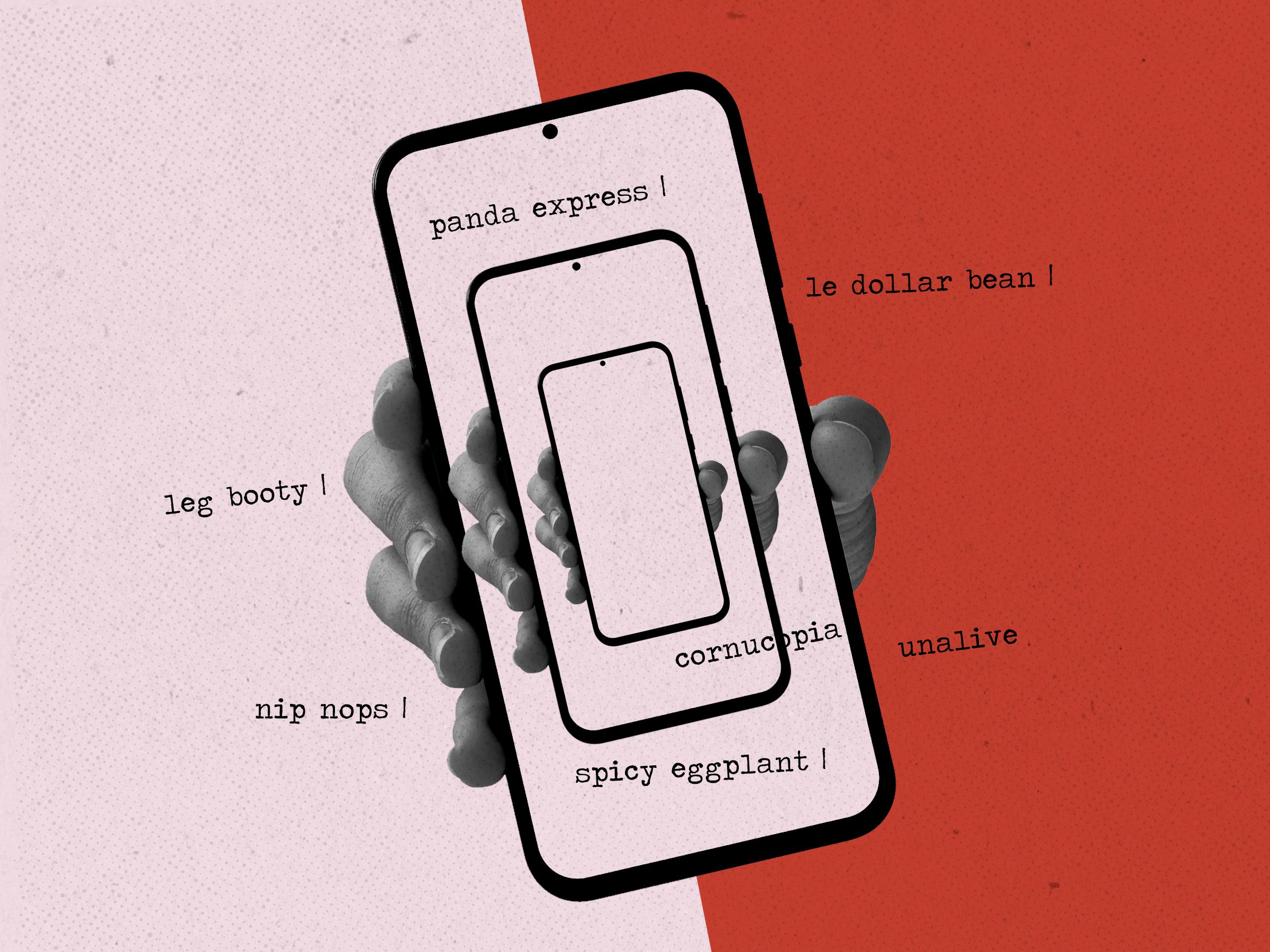

К сожалению, этот подход часто приводит к генерации так называемых «токсичных» текстов (с оскорбительной лексикой), что вызывает недоверие к таким системам для автоматизированного использования в бизнесе. Подобно маленькому ребенку, система не понимает слов, которые использует; она знает только то, что люди использовали их в похожем контексте.

Теперь исследователи из Института искусственного интеллекта Аллена (AI2) и Вашингтонского университета разработали новый способ машинного обучения данных систем, в том числе уменьшив их потенциал в отношении токсичной лексики.

«DExperts: быстрая автоматическая генерация текстов, контролируемая экспертами и антиэкспертами» — это новая статья группы исследователей, работающих над этой проблемой. Команда хотела понять, могут ли они управлять атрибутами текста, генерируемого языковыми моделями (LM), во время декодирования, при этом не исключая беглость речи или разнообразие лексики. Результатом стал подход, использующий две меньших LM, моделирующих текст с желательными и нежелательными атрибутами, чтобы «управлять» большими языковыми моделями, такими как GPT-3.

«Эти методы, основанные на тонкой настройке, сами модифицируют исходную языковую модель. Таким образом, во время декодирования они могут генерироваться напрямую из модели», — сказала Алиса Лю, ведущий автор статьи. «Мы совсем не изменяем исходную языковую модель. Вместо этого мы проводим тонкую настройку этих небольших экспертов».

Подход команды основан на традиционной технике машинного обучения, известной как «продукт экспертов», позволяющий комбинировать ряд более простых выходных данных для определения более крупной и сложной системы. Этот метод позволяет каждой меньшей модели специализироваться на анализе одного конкретного аспекта проблемы.

Вместо того, чтобы использовать только экспертов, команда DExperts добавила антиэкспертов. Исследователи считают, что это может быть первое использование комбинации экспертных и антиэкспертных LM, двух контрастирующих языковых моделей, которые были точно настроены на определенные данные атрибутов, специфичных для предметной области. Комбинируя их, сигнал, специфичный для предметной области, может быть нейтрализован, в то же время, можно направлять целевой LM в сторону определенного набора лексики (или же исключая определённую лексику, например, лексику оскорбительного характера)

Такой подход возникает во время декодирования и это дает ряд преимуществ. Конечные пользователи не могут загружать огромные наборы данных, такие как GPT-2 и GPT-3, для запуска на своем собственном компьютере или устройстве. Вместо этого эти языковые модели глубокого обучения должны работать с большими компьютерными кластерами и обычно доступны через API (интерфейс прикладного программирования). Из-за этого большая LM не может быть изменена напрямую, и здесь на помощь приходят меньшие LM.

«Мы работаем в этом пространстве языковых моделей, которые настолько велики, что мы даже не можем запустить их сами», — сказал Маартен Сап, один из авторов статьи. «И все же, что удивительно, наш метод все еще работает на такой большой модели. Таким образом, используя меньших экспертов, мы действительно можем управлять такой моделью, как GPT-3, что действительно здорово».

По мнению исследователей, DExperts превосходит существующие методы управления выбором лексики, а также существующие методы детоксикации. Хотя в исследовании рассматривалось только направление в сторону одного атрибута или от него, структура достаточно обширна, чтобы распространить ее на ряд экспертов и антиэкспертов. Предположительно, это позволило бы получить дополнительную выгоду от многоатрибутного метода «продукта экспертов», использующегося в машинном обучении.

Хотя многие компании в настоящее время разрабатывают продукты, использующие GPT-3, вероятность получения неточных или несоответствующих выводов по-прежнему затрудняет получение надежных результатов, особенно в определенных коммерческих условиях. Усовершенствования, подобные DExperts, могут привести к гораздо большему доверию и полезности при использовании этих моделей. От составления письма или предложения до автоматизации рецензий на фильмы и книги, создания виртуальных помощников, а также возможности более целенаправленно использовать генерацию естественного языка может принести пользу многочисленным приложениям.

Но хотя такие разработки, такие как DExperts, вероятно, приведут ко многим новым достижениям и преимуществам, существует также перспектива неправильного использования, которую не следует игнорировать. Исследователи признают, что существует потенциал для использования данных методов для автоматического синтеза ненавистнических или экстремистских текстов. Поскольку автоматическая генерация текстов становится все более усовершенствованной, мошенники и хакеры также могут использовать ее для манипулирования неосторожными людьми. Текстовые чат-боты и мошенничество в электронной почте на основе ИИ становятся все более распространенными в последние годы. Намечается расширение таких мошеннических схем, включая синтезированную голосовую связь.

Эти опасения не новы. Поскольку каждая новая технология приводит к неожиданному использованию и непредвиденным последствиям, полезно подумать о том, как можно было бы включить меры предосторожности на ранних этапах цикла разработки.

Как генерация естественного языка может стать более устойчивой и надежной в будущем? Забегая вперед, мы можем предположить, что такой метод, как нейронное алгоритмическое мышление, сыграет важную роль. Недавно описанный в статье исследователей из DeepMind, этот метод объединяет нейронные сети, подобные языковым моделям (описанным выше), с алгоритмическими вычислениями на основе правил для создания более надежного конвейера выражений, комбинируя сильные стороны двух подходов .

Способность DExperts управлять мощными LM, такими как GPT-3, во время декодирования может иметь огромный потенциал для бизнеса и потребителей, автоматизируя многие повторяющиеся административные задачи и упрощая повседневную рутину в нашей жизни. Кроме того, эти приложения довольно экологичны.

«Поскольку этот подход работает во время генерации, вы не выполняете обучение всей модели снова и совершаете гораздо меньше вычислений», — отметил Сап. «Таким образом, это уменьшает углеродный след и соответствует принципам экологичного использования ИИ, в чем также заинтересован AI2».