В начале марта было распространено сфальсифицированное видео президента Украины, где сгенерированный цифровым способом Владимир Зеленский приказал украинской национальной армии сдаться. Видео распространилось в Интернете, но было быстро разоблачено как дипфейк — гиперреалистичное, но поддельное видео, созданное с использованием искусственного интеллекта.

Хотя российская дезинформация, похоже, оказывает ограниченное влияние, этот тревожный случай иллюстрирует потенциальные последствия дипфейков.

Однако дипфейки успешно используются и в вспомогательных технологиях. Например, люди, страдающие болезнью Паркинсона, могут использовать клонирование голоса для общения.

А также в образовании: ирландская компания по синтезу речи CereProc создала синтетический голос для Джона Ф. Кеннеди, вернув его к жизни, чтобы он произнес свою знаменитую речь.

Но у каждой медали есть две стороны. Дипфейки могут быть практически незаметными для человеческого глаза.

Следовательно, одна и та же технология клонирования голоса может использоваться для фишинга, клеветы и шантажа. Когда дипфейки преднамеренно используются для изменения общественного мнения, разжигания социальных конфликтов и манипулирования выборами, они подрывают демократию.

Причина хаоса

Дипфейки основаны на технологии, известной как генеративно-состязательные сети, в которых два алгоритма обучают друг друга создавать изображения.

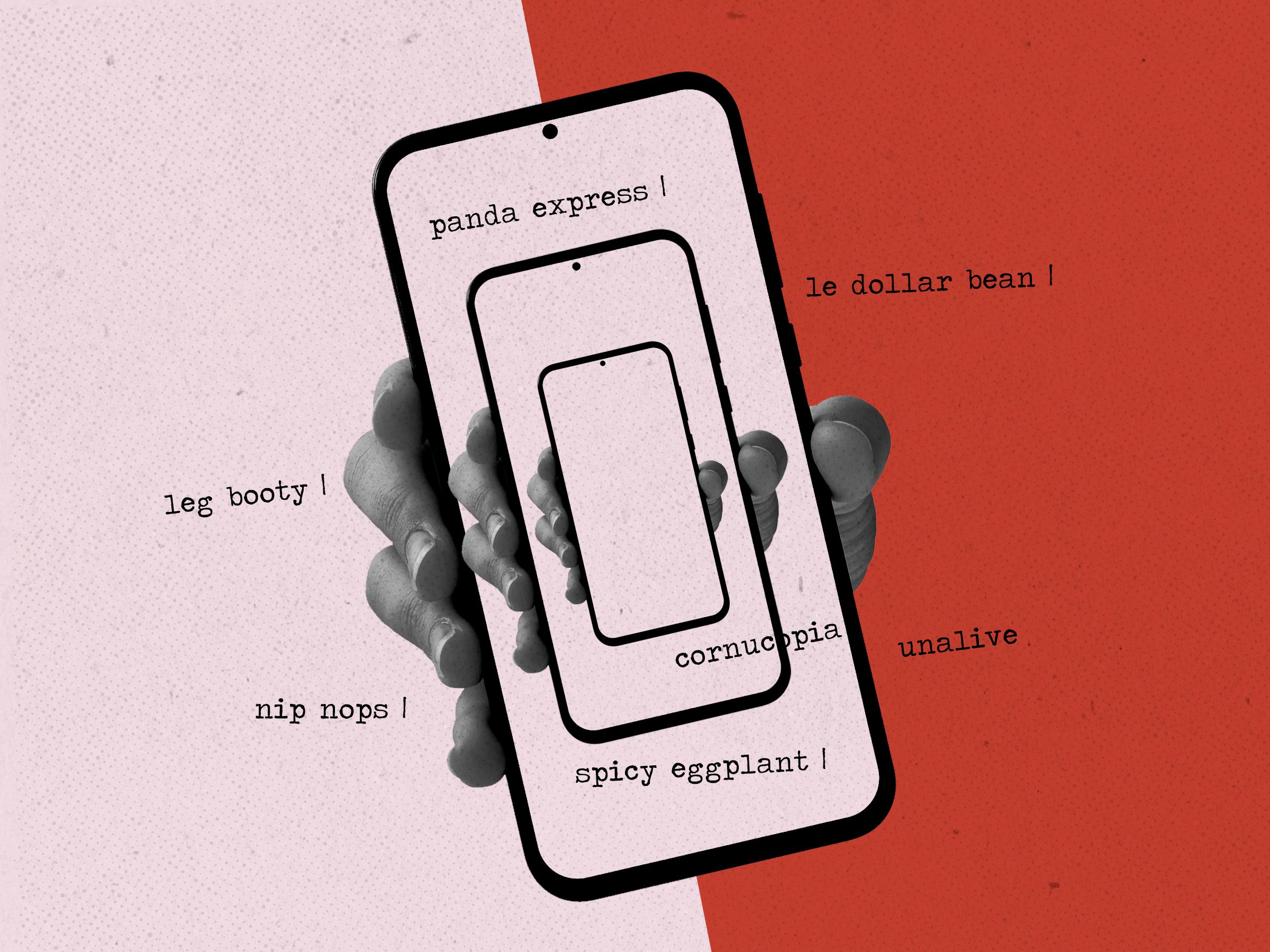

Хотя технология дипфейков кажется сложной, создать ее нетрудно. Существует множество онлайн-приложений, таких как Faceswap и ZAO Deepswap, которые создают дипфейки за считанные минуты. Google Colaboratory — онлайн-хранилище кода на нескольких языках программирования — содержит примеры кода, который используется для создания поддельных изображений и видео. С таким доступным программным обеспечением легко увидеть, как обычные пользователи могут сеять хаос с помощью дипфейков, не осознавая потенциальных рисков безопасности.

Популярность приложений и онлайн-сервисов для смены лица, таких как Deep Nostalgia, показывает, насколько быстро они могут быть приняты широкими слоями населения. В 2019 году было обнаружено приблизительно 15 000 видео с использованием дипфейков. И ожидается, что это число будет расти.

Дипфейки — идеальный инструмент для кампаний по дезинформации, потому что они производят правдоподобные фейковые новости, на разоблачение которых требуется время. Между тем ущерб, наносимый дипфейками, особенно тот, который влияет на репутацию людей, часто является длительным и необратимым.

Увидеть – значит поверить?

Возможно, наиболее опасным проявлением дипфейков является то, как они поддаются дезинформации в политических кампаниях.

Мы видели, как Дональд Трамп называл любое нелестное освещение в СМИ «фейковыми новостями». Обвиняя своих критиков в распространении фейковых новостей, Трамп использовал дезинформацию для защиты своих правонарушений и в качестве инструмента пропаганды.

Стратегия Трампа позволяет ему сохранять поддержку в среде, наполненной недоверием и дезинформацией, заявляя, что «истинные события и истории являются фейковыми новостями или дипфейками».

Доверие к властям и СМИ подрывается, создавая соответствующую атмосферу. А с растущим распространением дипфейков политики могут легко отрицать свою вину в любых возникающих скандалах. Как подтвердить чью-то личность на видео, если они это отрицают?

Борьба с дезинформацией всегда была проблемой для демократий, пытающихся защитить свободу слова. Партнерство человека и ИИ в силах помочь справиться с растущим риском дипфейков, заставив людей проверять информацию. Также необходимо рассмотреть введение нового законодательства или применение существующих законов для наказания производителей дипфейков за фальсификацию информации и выдачу себя за других людей.

Междисциплинарные подходы международных и национальных правительств, частных компаний и других организаций жизненно важны для защиты.

Источник: https://theconversation.com/ Перевод: Давлетова Дария